Hallo Mathematiker.

Da ich mich momentan etwas eingehender mit Data Science und KI beschäftige möchte ich gerade auf Jux mal ein Wettervorhersage-Programm schreiben welches mir basierend auf den vorangegangenen Tagen/Wochen, das Wetter von morgen und übermorgen vorhersagt.

Bevor jetzt wissenschaftliche Einwände kommen, dass dies kaum zu seriösem Erfolg führen wird. Es geht hierbei nur um den Lerneffekt!

Dabei wollte ich jetzt erst einmal mit den Temperaturen anfangen. Also einfach die maximalen Tagestemperaturen.

Aber hier kam dann bei mir die Frage auf: Wie stellt man eigentliche eine entsprechende Funktionsgleichung auf? Diese wird ja keiner wirklichen Funktion entsprechen, zumindest keiner offensichtlichen, sondern dürfte sehr viele Grade haben.

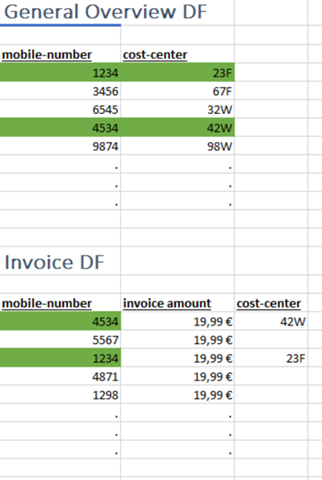

Auch das x ist ja im Grunde halb-flexible. Ob die Punkte jetzt x=1,2,3,4,... oder x=20,27,34,41,... folgen ist mir einerlei, so lange ich weiß welches x den nächsten und übernächsten Tag darstellt.

Angenommen ich hätte jetzt ein paar Beispieldaten von einer Woche (die stimmen nicht, sind nur schnell hingetippt):

(15/13), (16/9), (17/7), (18/12), (19/14), (20/22), (21/15)

und wollte mir damit nun per Annäherung die Funktionsgleichung ermitteln, wie ginge das?

Mit OpenOffice und Excel kann man sich ja z. B. in einem Diagramm die berechnete Funktionsgleichung mit Bestimmtheitsmaß anzeigen lassen. Allerdings nur für lineare oder exponentielle Gleichungen usw., aber nichts was für meine Zwecke zu gebrauchen wäre.

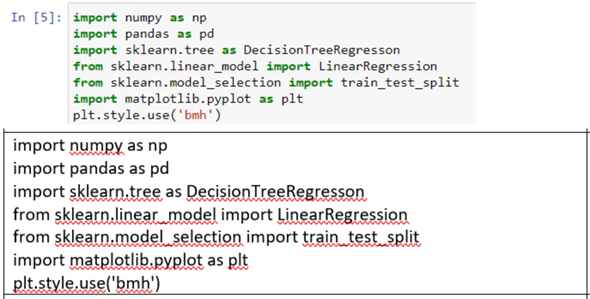

Wie macht man sowas? Gibt es online vielleicht bereits einen Rechner dafür? Oder kennt jemand eine Bibliothek (bestenfalls Python) wo sowas integriert ist?

Vielen Dank für hilfreiche Antworten.