Hallo,

ich versuche eine Bild-KI in Colab mit Tensorflow Keras zu erstellen, aber irgendwie geht es nicht so recht.

latent_dim = 100

# Generator-Modell definieren

generator = keras.models.Sequential()

generator.add(layers.Dense(25 * 25 * 6, input_shape=(latent_dim,))) # Anpassung der Anzahl der Ausgabe-Features

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Reshape((25, 25, 6))) # Anpassung der Ausgabeformate

generator.add(layers.Conv2DTranspose(12, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Conv2DTranspose(12, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Conv2DTranspose(24, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

# Diskriminator-Modell definieren

discriminator = keras.models.Sequential()

discriminator.add(layers.Conv2D(12, kernel_size=4, strides=2, padding="same", input_shape=(100, 100, 24))) # Anpassung der Eingabeformate

discriminator.add(layers.LeakyReLU(alpha=0.2))

discriminator.add(layers.Conv2D(6, kernel_size=4, strides=2, padding="same"))

discriminator.add(layers.LeakyReLU(alpha=0.2))

discriminator.add(layers.Flatten())

discriminator.add(layers.Dense(1, activation='sigmoid'))

# GAN-Modell erstellen

gan = keras.models.Sequential()

gan.add(generator)

gan.add(discriminator)

latent_dim = 100

generator = keras.models.Sequential()

generator.add(layers.Dense(25 * 25 * 6, input_shape=(latent_dim,))) # Anpassung der Anzahl der Ausgabe-Features

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Reshape((25, 25, 6))) # Anpassung der Ausgabeformate

generator.add(layers.Conv2DTranspose(12, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Conv2DTranspose(12, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

generator.add(layers.Conv2DTranspose(24, kernel_size=4, strides=2, padding="same"))

generator.add(layers.LeakyReLU(alpha=0.2))

discriminator = keras.models.Sequential()

discriminator.add(layers.Conv2D(12, kernel_size=4, strides=2, padding="same", input_shape=(100, 100, 24))) # Anpassung der Eingabeformate

discriminator.add(layers.LeakyReLU(alpha=0.2))

discriminator.add(layers.Conv2D(6, kernel_size=4, strides=2, padding="same"))

discriminator.add(layers.LeakyReLU(alpha=0.2))

discriminator.add(layers.Flatten())

discriminator.add(layers.Dense(1, activation='sigmoid'))

gan = keras.models.Sequential()

gan.add(generator)

gan.add(discriminator)

Das Bild hat eine Größe von 100x100 Pixeln und eine Bit-Tiefe von 24.

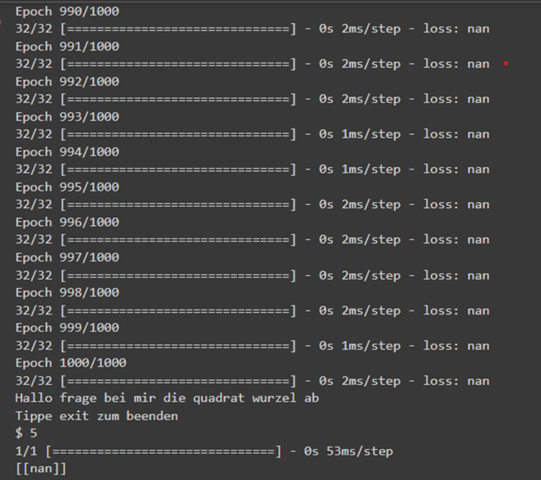

Der Compiler sagt das hier:

ValueError: Exception encountered when calling layer "sequential_77" (type Sequential).

Input 0 of layer "dense_75" is incompatible with the layer: expected axis -1 of input shape to have value 3750, but received input with shape (None, 15000)

Ich würde mich über eine Antwort freuen.

Jannik